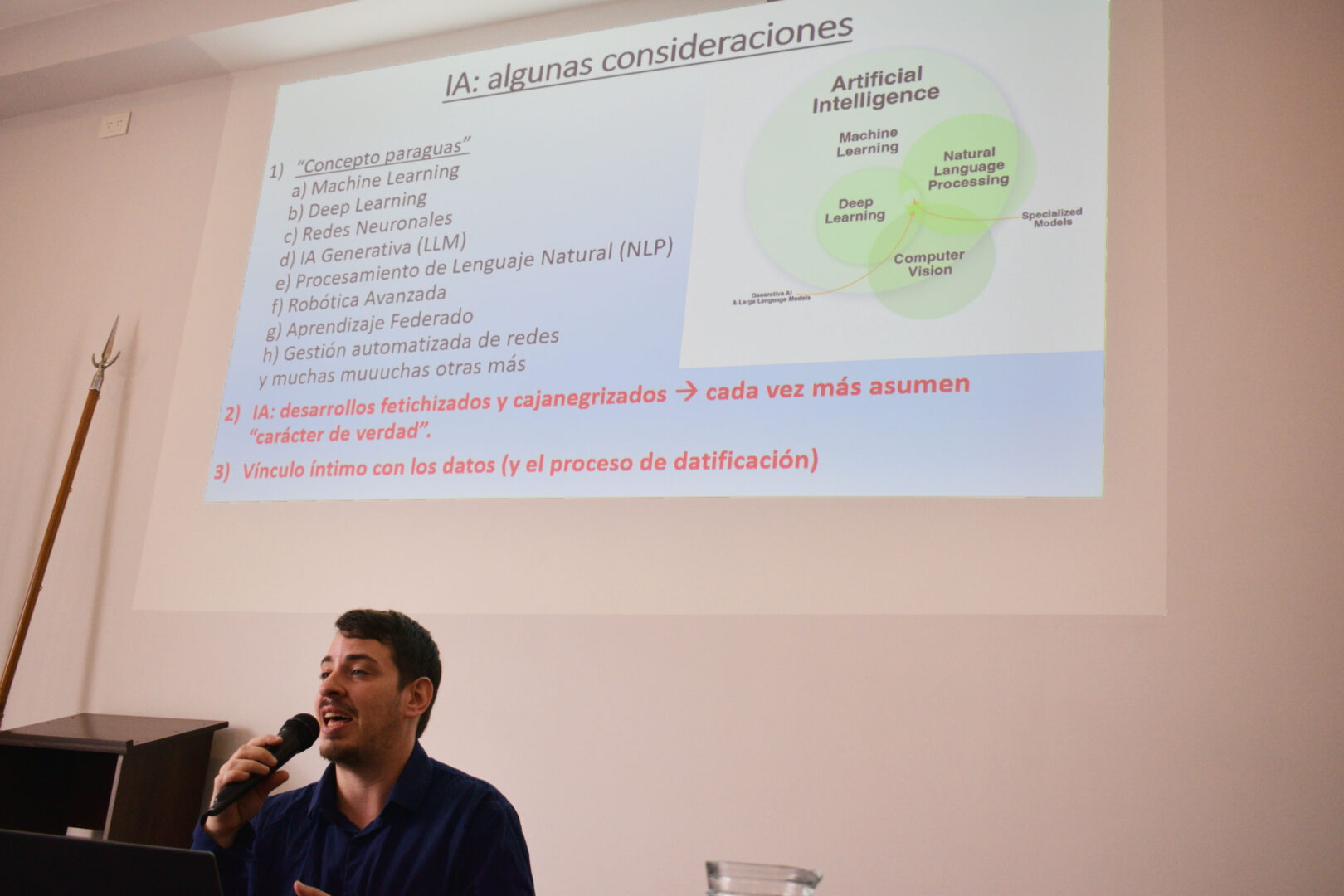

El 15 de mayo se realizó en la FTS el curso «Inteligencia Artificial (IA) y Universidad. ¿Cómo pensar y aplicar de forma ética, efectiva y segura?», a cargo del doctor Martín Ariel Gendler. También se dicta, con el mismo nombre y hasta el mes de julio, un taller de cuatro encuentros dirigido a las personas que realizan tareas administrativas, técnicas y de servicios en áreas claves de la Facultad

En ese marco, desde el Área de Comunicación conversamos con Gendler, quien integra el Programa de Investigaciones sobre la Sociedad de la Información, del Instituto Gino Germani (FSOC-UBA) – CONICET.

— En el espacio del curso dictado en la FTS, comentaste que, contrariamente a lo que indica su nombre, la IA no es inteligente, ¿nos podés explicar esa afirmación?

— A ver, no es inteligente primero y principal porque funciona de una forma probabilística, es decir, siempre nos va a responder o a producir, a decirnos algo, en función de los datos que tiene disponible para, justamente, proporcionarnos una respuesta.

Es decir, no hay una capacidad de autorreflexión, no hay otro tipo de inferencias, no hay una trayectoria personal, no hay una historia de vida, no hay un contexto necesariamente cultural, porque lo que va a hacer cada vez que le pedimos algo es ir a buscarlo y nos va a responder lo que puede ser más probable; ahí también es que pueden surgir las famosas alucinaciones: cuando la probabilidad no se ajusta a lo que le estamos pidiendo.

Tampoco hay en la IA una capacidad de aprendizaje necesariamente como lo que hacemos nosotros de tener en cuenta esta cuestión u otra, sino que siempre va a estar trabajando en esto de la probabilidad, cosa que tiene sus limitaciones, porque nosotros no funcionamos necesariamente en función de probabilidad, tenemos muchas más variables y muchas más complejidades.

— Otro planteo que hiciste durante el curso es que la IA no es una herramienta, ¿a qué te referías con eso?

— Cuando uno la piensa como herramienta, está pensando en algo «que sirva para»: no va a haber nada más que el uso que le doy. Esto tiene que ver con cuestiones de filosofía de la técnica y demás, donde la herramienta va a ser buena o mala según el uso que yo le dé: si el martillo lo uso para clavar un clavo va a ser un buen uso, si lo uso para partir la cabeza de alguien o robar un auto va a ser un mal uso. Eso es lo que pasa cuando pensamos algo como una herramienta: se le quita toda «culpa» a ese dispositivo, en este caso al martillo; el martillo no tiene la culpa, soy yo el que lo uso para bien o para mal.

Con la IA el tema es distinto por varias cuestiones. En primer lugar porque, justamente, no es que simplemente nos va a estar dando una respuesta: va a estar trabajando con base de datos en función de ciertos parámetros con los que fue entrenado, que pueden contener una multiplicidad de sesgos, como por ejemplo que de respuestas más favorables cuando se pregunte por algo respecto de un varón que de una mujer (…) Entonces esto no tiene que ver con el uso que yo le doy, sino también con cómo fue entrenado. Y, más allá de eso, el martillo, repito, sirve o romper el vidrio del auto o para clavar el clavo, pero la IA hace muchas cosas también con lo que le estamos preguntando, es decir, todos esos datos que estamos dando; y también esos datos pueden ya ser vendidos. Entonces, la situación con la IA va mucho más allá que simplemente el uso que yo doy. Tiene una concatenación de actores, una concatenación de problemáticas, de las cuales tenemos que estar siempre advertidos y advertidas a la hora de utilizarlo, justamente porque no es inocente, sino que es parte de un engranaje de una cosa mucho más amplia. Usémoslo con cierta conciencia, cierta criticidad, más allá del uso que le demos tenemos que entender todo el trasfondo de esto, porque es fundamental para contextualizarlo en tiempo y espacio.

Fuente: Área de Comunicación Institucional FTS-UNER